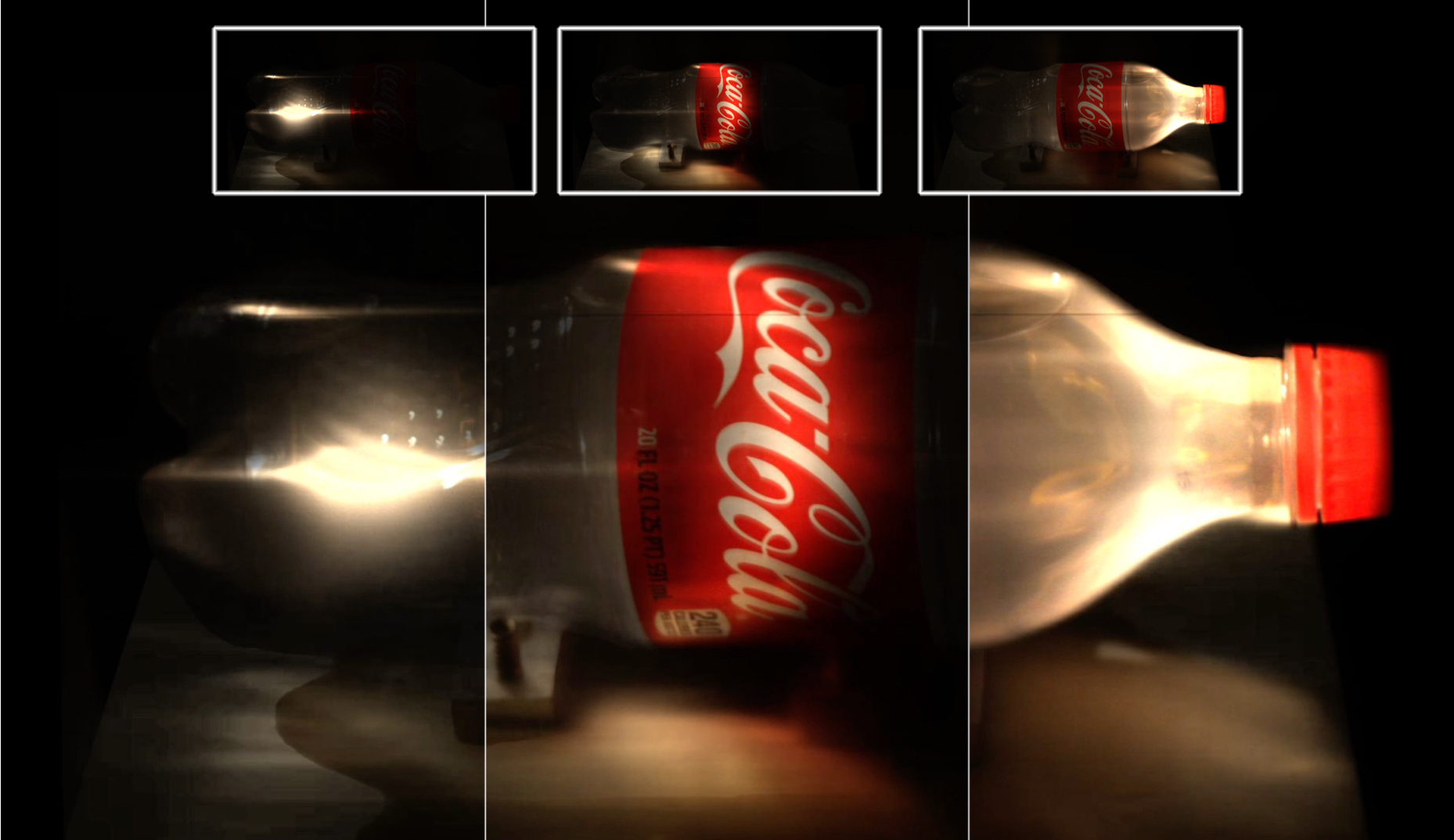

En 2013 investigadores del MIT y la Universidad de Zaragoza, presentaron un sistema de imagen ultrarrápida bautizado como femtofotografía, llevando la velocidad de captura de una cámara a nuevos límites: por primera vez, se podían capturar eventos ocurriendo en billonésimas de segundo; velocidad suficiente como ver la propagación de la luz. A esa resolución temporal (un fotograma cada 2 picosegundos) la luz avanza menos de un milímetro por fotograma (Figura 1). Esta enorme cantidad de información codificada en el dominio temporal abre nuevas oportunidades y desafíos, permitiendo ver lo invisible: desde escenas con escasa iluminación, de poca visibilidad por la presencia de medios turbios como la niebla, e incluso totalmente ocluidas o fuera de la línea de visión (a través de esquinas).

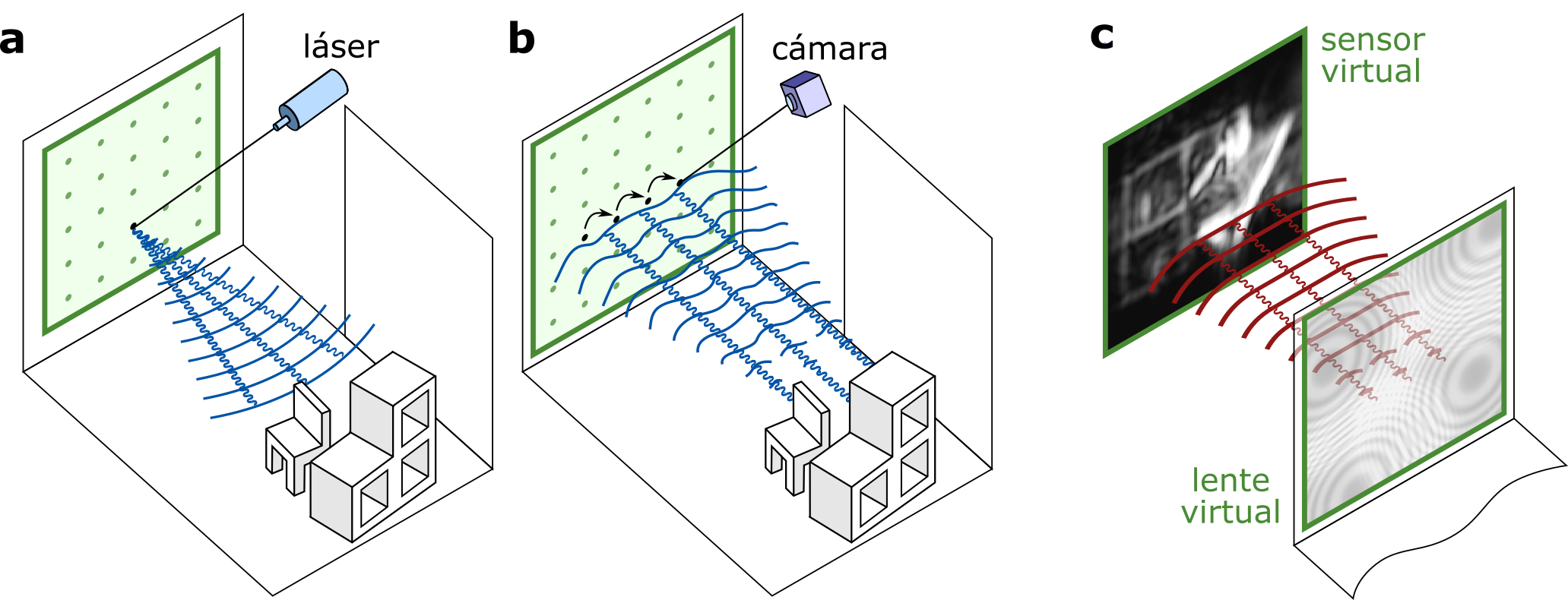

En esta línea, investigadores de la Universidad de Zaragoza y University of Wisconsin-Madison demostraron en 2019 que esta información se podía codificar como campos de ondas virtuales (phasor fields) de tal forma que cualquier pared puede transformarse computacionalmente en una cámara virtual, y así cualquier técnica óptica o de visión por computador podía aplicarse desde dicha pared en lugar de desde la cámara real. Por primera vez se podía fotografiar computacionalmente escenas de tamaño y complejidad real fuera de la línea de visión (ocluidas tras una esquina) como muestra en la Figura 2.

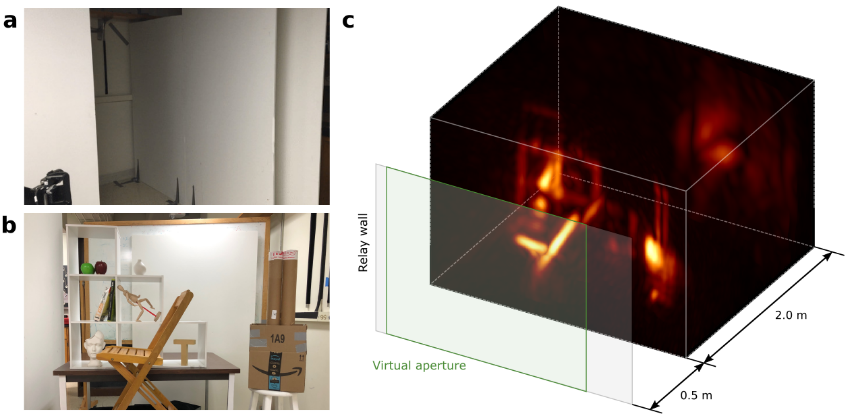

Esta flexibilidad para introducir sistemas ópticos arbitrarios de forma computacional tiene un enorme potencial no sólo para fotografiar escenas ocultas, sino también para aplicar otras técnicas computacionales: por ejemplo, mediante el enfoque de esta cámara virtual a diferentes distancias se pueden reconstruir representaciones tridimensionales de la escena oculta, como se observa en la Figura 3.

La hipótesis fundamental de este proyecto es que esto no es solo una técnica más de reconstrucción de geometría oculta, sino una metodología que puede ser generalizada a otras aplicaciones en las que los elementos ópticos (cámaras, fuentes de luz) sean virtuales, basados en transformaciones del transporte de luz temporal capturado. Así, diferentes algoritmos clásicos de visión por computador y óptica computacional, diseñados sobre elementos ópticos reales, pueden ser adaptados a estas representaciones virtuales de los mismos elementos ópticos, mucho más allá de la reconstrucción mostrada en la Figura 3.

Este proyecto pretende utilizar esta metodología, explotándola en dos ejes fundamentales: primero generalizar el modelo de ondas que permite la transformación de la señal temporal a óptica virtual para flexibilizar la aplicación a escenas más complejas. Con esto se espera conseguir eliminar restricciones en la geometría de paredes (permitiendo paredes no planas e irregulares), permitir la captura en el caso de medios participativos (como nieblas o escenas subacuáticas) y explorar no sólo la visión virtual de una escena ocluida tras una pared sino tras varias paredes.

El otro eje en el que se espera obtener resultados es en el de expandir las aplicaciones de un sistema óptico virtual a técnicas clásicas de imagen computacional y visión por computador, que tradicionalmente funcionan bien en sistemas ópticos reales. Esto permitirá no sólo reconstrucciones básicas tridimensionales, sino recuperación de geometría compleja, captura de propiedades de materiales ocultos en la escena o separación de los diferentes componentes ocluidos de la iluminación. La combinación de los avances en ambos ejes (generalización del modelo de ondas y expansión de aplicaciones) abrirán un nuevo abanico de posibilidades en técnicas de visión por computador.

La tecnología de imagen ultrarrápida, su aplicación a reconstrucción de escenas fuera de la línea de visión y su flexibilización para escenas más generales tiene un enorme potencial en campos como la robótica, los vehículos autónomos, situaciones de rescate, seguridad o defensa. La capacidad de reconocer y reconstruir escenas ocluidas permitiría planificar movimientos, prevenir colisiones con objetos móviles ocultos y detectar potenciales amenazas de forma segura. Una indicación de este potencial es la inversión del Departamento de Defensa de EEUU a través de su Agencia de Investigación Avanzada (DARPA) en este tipo de tecnologías

La reconstrucción de geometría y propiedades ópticas a través de medios turbios tiene también aplicaciones médicas como la tomografía óptica, de tal forma que tejidos bajo la piel pueden ser detectados y analizados de forma no invasiva.

Esta tecnología también tiene un gran potencial en aplicaciones de exploración remota y mapeo en superficies complejas como cuevas, cavidades y simas submarinas, o glaciares. En este contexto, el programa PERISCOPE de NASA plantea el uso de tecnología de reconstrucción de geometría no visible para cartografiar de forma remota (desde satélite) cuevas lunares. Aplicando metodologías similares se podría explorar, inspeccionar y reconstruir virtualmente objetos y edificios de patrimonio cultural sin necesidad de alteración física.

Adolfo Muñoz es Profesor Contratado Doctor del Departamento de Informática e Ingeniería de Sistemas de la Universidad de Zaragoza, con docencia en la Escuela de Ingeniería y Arquitectura. En abril de 2010 defendió su tesis doctoral titulada Light Transport in Participating Media (dirigida por Diego Gutierrez y Francisco J. Seron), que estableció sus áreas principales de investigación, incluyendo la simulación del transporte de luz y la captura y modelado de apariencia de materiales. Posteriormente incorporó otros intereses como la imagen computacional. Pertenece al Graphics and Imaging Lab. Ha publicado en revistas de alto impacto, y mostrado su capacidad de trabajo en equipos internacionales (con co-autores de varias instituciones a nivel mundial) así como su propia capacidad personal como investigador. (con una publicación en primer cuartil con un único autor).

Diego Gutiérrez es catedrático de Universidad, Doctor Ingeniero Informático por la Universidad de Zaragoza (2005, Premio Extraordinario de Doctorado). Su actividad investigadora se centra en el campo de la informática gráfica, realidad virtual e imagen computacional. En 2008 fundó el Graphics and Imaging Lab, grupo de investigación de referencia reconocido por el Gobierno de Aragón. Ha publicado más de 100 artículos en revistas de alto impacto, incluyendo la revista Nature. En 2014 fue premiado por Google con una Faculty Scholar Award y en 2015 consiguió un ERC Consolidator Grant, la financiación individual de más prestigio en Europa. Ha trabajado en universidades como el MIT o Stanford, y colabora con empresas e instituciones como Disney o NASA. En la actualidad es también socio fundador de DIVE, una start-up médica dedicada a la prevención de patologías visuales en bebés y pacientes no colaborativos.